Möjligheten av medveten AI uppfattas alltmer som en legitim och angelägen vetenskaplig fråga. Detta intresse har uppstått efter en lång historia av vetenskapliga tvivel på möjligheten av medvetande inte bara hos andra djur, utan ibland rentav hos människan. Själva begreppet medvetande ansågs under en period vara vetenskapligt suspekt. Men nu ställs alltså frågan om medveten AI inom vetenskapen.

För den som är intresserad av hur en så halsbrytande fråga kan besvaras filosofiskt och vetenskapligt, vill jag rekommendera ett intressant AI-filosofiskt tankeutbyte i den franska tidskriften Intellectica. Tankeutbytet (som är på engelska) kretsar kring en artikel av två filosofer, Jonathan Birch och Kristin Andrews, som under flera år diskuterat medvetande inte bara bland däggdjur, utan även bland fåglar, fiskar, bläckfiskar, kräftdjur, reptiler, groddjur och insekter. De två filosoferna skiljer noga mellan psykologiska frågor om vad som kan göra oss emotionellt lockade att tro att ett AI-system är medvetet, och logiska frågor om vad som filosofiskt och vetenskapligt kan räknas som evidens för medveten AI. Det är till detta logiska perspektiv som de vill bidra. Hur kan vi avgöra om ett artificiellt system verkligen är medvetet; inte bara förföras till att tro det för att systemet emotionellt övertygande speglar beteendet hos subjektivt upplevande människor? Deras grundtanke är att vi först bör studera medvetande hos ett brett spektrum av djurarter bortom däggdjuren. Dels för att människohjärnan skiljer sig alltför mycket från (dagens) artificiella system för att fungera som lämplig utgångspunkt, men framförallt för att sådan bred jämförelse kan hjälpa oss att identifiera de väsentliga dragen hos medvetandet: drag som kunde användas som markörer för medvetande i artificiella system. De två filosofernas förslag är alltså att vi, genom att utgå från olika former av djurmedvetande, bättre kan förstå hur vi filosofiskt och vetenskapligt bör söka evidens för eller emot medveten AI.

En av mina kollegor vid CRB, Kathinka Evers, även hon filosof, kommenterar artikeln. Hon uppskattar Birch och Andrews diskussion som filosofiskt klargörande och ser förslaget att närma sig frågan om medveten AI via studium av medvetandeformer hos ett brett spektrum djurarter som väl underbyggt. Hon menar dock att ett antal frågor fordrar mer uppmärksamhet. Bland annat frågar hon om inte övergången från kol- till kiselbaserade substrat fordrar större uppmärksamhet än Birch och Andrews ger den.

Birch och Andrews föreslår ett tankeexperiment där en robotråtta beter sig exakt som en verklig råtta. Den klarar samma kognitiva och beteendemässiga tester. De antar vidare att råtthjärnan avbildats exakt i roboten, neuron för neuron. I ett sådant fall, menar de, vore det inkonsekvent att inte acceptera samma smärtmarkörer som gäller för råttan även för roboten. Fallen är lika, menar de, övergången från kol till kisel ger inte tillräckliga skäl för att betvivla att robotråttan kan känna smärta när den uppvisar samma drag som markerar smärta hos den verkliga råttan. Men fallen är ju inte lika, påpekar Kathinka Evers, för den verkliga råttan är, till skillnad från roboten, levande. Om liv är väsentligt för medvetande så är det inte inkonsekvent att betvivla att roboten kan känna smärta ens i detta tankeexperiment. Någon kunde givetvis förknippa liv med medvetande och hävda att en robotråtta som uppvisar de väsentliga dragen för medvetande också måste betraktas som levande. Men om syftet är att identifiera vad som logiskt kan fungera som evidens för medveten AI så kvarstår problemet, menar Kathinka Evers, för vi behöver då klargöra hur relationen mellan liv och medvetande ska undersökas och hur begreppen ska definieras.

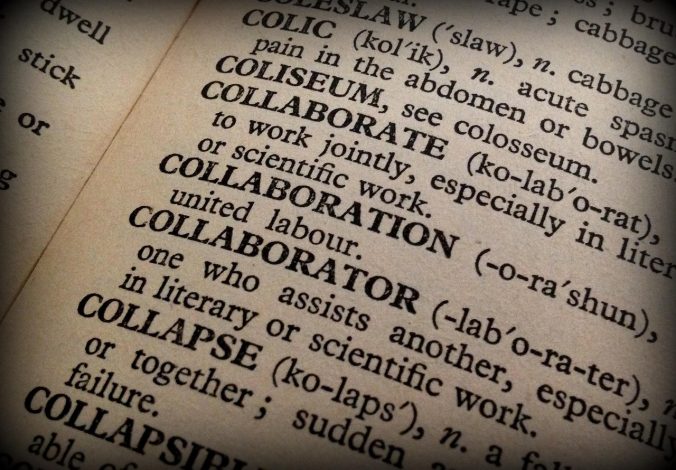

Kathinka Evers föreslår alltså flera frågor av relevans för vad som logiskt kan räknas som evidens för medveten AI. Men hon ställer också en mer grundläggande fråga, som kan anas genom hela hennes kommentar. Hon frågar varför frågan om konstgjort medvetande alls ställs inom vetenskapen idag. Ett av Birch och Andrews syften var som sagt att undvika att svaret styrs av psykologiska tendenser att tolka en AI som övertygande speglar mänskliga känslor som om den vore medveten. Men Kathinka Evers frågar, som jag läser henne, om inte detta logiska syfte möjligen kommer för sent. Är inte redan frågan en frestelse? AI är tränad på människogenererade data för att spegla mänskligt beteende, påpekar hon. Söker vi måhända filosofisk och vetenskaplig evidens kring en fråga som tycks betydelsefull bara för att vi har en psykologisk tendens att identifiera oss med våra digitala spegelbilder? För att en fråga ska betraktas som vetenskaplig och värd att finansieras krävs vanligen något slags initialt empiriskt stöd, men det finns överhuvudtaget ingen evidens för möjligheten av medvetande hos icke-levande entiteter såsom AI-system. Frågan om en AI kan vara medveten har inte mer empiriskt stöd än frågan om vulkaner kan uppleva sina utbrott, påpekar Kathinka Evers. Risken är stor att vi vetenskapligt försöker besvara en fråga som saknar vetenskaplig grund. Hur försiktigt vi än söker det efterlängtade svaret, så tycks frågan oförsiktig.

Jag kommer att tänka på myten om Narcissus. Efter en lång historia av avvisanden av andras kärlek (andras medvetande), förälskade han sig slutligen i sin egen (digitala) spegelbild, sökte hopplöst att krama den, och plågades sedan av en evig längtan efter bilden. Är du där? Kommer spegelbilden att svara? En AI kommer säkert att generera en respons som talar till våra mänskliga känslor.

Skrivet av…

Pär Segerdahl, docent i filosofi vid Centrum för forsknings- och bioetik och redaktör för Etikbloggen.

Birch Jonathan, Andrews Kristin (2024/2). To Understand AI Sentience, First Understand it in Animals. In Gefen Alexandre & Huneman Philippe (Eds), Philosophies of AI: thinking and writing with LLMs, Intellectica, 81, pp. 213-226.

Evers Kathinka (2024/2). To understand sentience in AI first understand it in animals. Commentary to Jonathan Birch and Kristin Andrews. In Gefen Alexandre & Huneman Philippe (Eds), Philosophies of AI: thinking and writing with LLMs, Intellectica, 81, pp. 229-232.

Vi söker klarhet

Senaste kommentarer