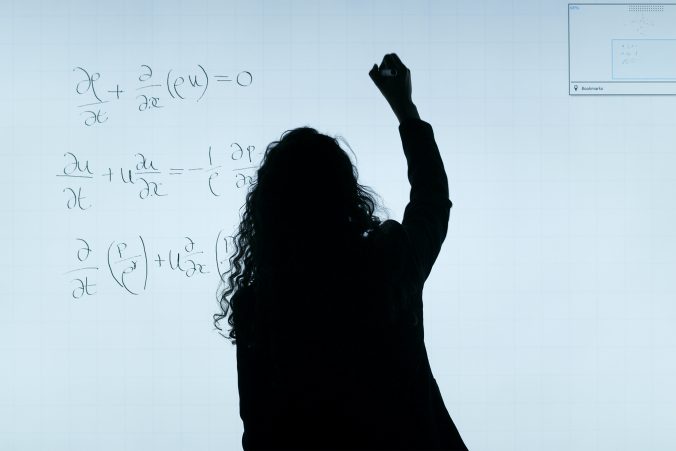

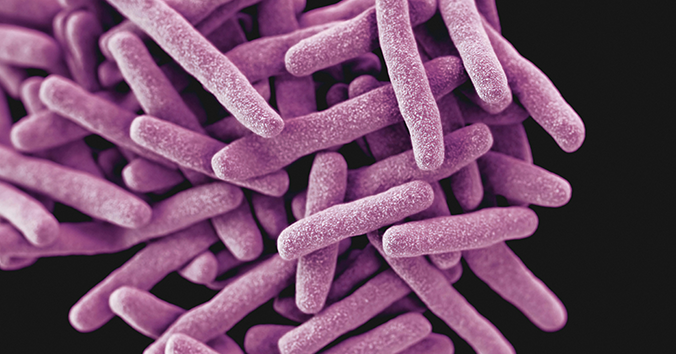

De flesta är antagligen medvetna om att antibiotikaresistens är ett de stora hoten mot hälsan globalt. När mikroorganismer utvecklar motståndskraft mot antibiotika blir fler människor allvarligt sjuka av vanliga infektioner och fler kommer att dö av dem. Det liknar en kapprustning. Genom att använda antibiotika för att försvara oss mot infektioner skyndar vi på utvecklingen av resistens. Eftersom vi behöver kunna försvara oss mot infektioner måste antibiotika användas mer ansvarsfullt så att resistensutvecklingen bromsas.

Däremot är inte alla lika medvetna om att även livsmedelsproduktion kraftigt bidrar till resistensutvecklingen. I djurhållningen runtom i världen används stora mängder antibiotika för att försvara djuren mot infektioner. Resistensutvecklingen accelereras inte minst här, när de mikroorganismer som överlever antibiotikan förökar sig och sprids. Dessutom kan antibiotika från djurhållning läcka ut och ytterligare påskynda resistensutvecklingen i en antibiotikaförorenad miljö. Inte minst inom livsmedelssektorn fordras således större ansvar för en bättre djurhållning med minskad antibiotikaanvändning.

Tyvärr verkar de berörda aktörerna inte känna sig ansvariga för den accelererade utvecklingen av resistens. Det finns så många aktörer i livsmedelskedjan: beslutsfattare på olika områden, producenter av olika slag, återförsäljare och konsumenter. När så många olika aktörer har gemensamt ansvar är det lätt hänt att alla håller någon annan ansvarig. En ny artikel (med Mirko Ancillotti vid CRB som en av medförfattarna) diskuterar en möjlighet för hur detta stillestånd där ingen känner sig ansvarig kan brytas: genom att stärka konsumenter att utöva den makt de faktiskt har. De är inte så passiva som vi tror. Tvärtom, genom sina köpbeslut, och genom att på olika sätt kommunicera sina val, kan konsumenter sätta press på såväl andra konsumenter som övriga aktörer i livsmedelskedjan. De kan kräva mer insyn och en bättre djurhållning som inte är lika antibiotikaberoende.

Antibiotikaresistens diskuteras emellertid ofta ur ett medicinskt perspektiv, vilket gör det svårt för livsmedelskonsumenter att se hur deras val i butiken skulle kunna påverka resistensutvecklingen. Genom att ändra på detta och stärka konsumenter att göra mer medvetna val skulle de kunna utöva sin konsumentmakt och påverka samtliga aktörer att ta gemensamt ansvar för livsmedelsproduktionens bidrag till antibiotikaresistensen, resonerar artikelförfattarna. Tendensen att förlägga ansvaret hos någon annan kan brytas om konsumenter genom sina köpbeslut kräver bättre insyn och större ansvarstagande. Beslutsfattare, livsmedelsproducenter, återförsäljare och konsumenter får incitament att samarbeta för att bromsa resistensutvecklingen.

Artikeln diskuterar ansvarighetsproblematiken från ett teoretiskt perspektiv som kan motivera interventioner och empiriska studier. Läs artikeln här: Antimicrobial resistance and the non-accountability effect on consumers’ behaviour.

Skrivet av…

Pär Segerdahl, docent i filosofi vid Centrum för forsknings- och bioetik och redaktör för Etikbloggen.

Nordvall, A-C., Ancillotti, M., Oljans, E., Nilsson, E. (2025). Antimicrobial resistance and the non-accountability effect on consumers’ behaviour. Social Responsibility Journal. DOI: 10.1108/SRJ-12-2023-0721

Vi diskuterar aktuella frågor

Senaste kommentarer