Att vara etiker och filosof är att vara en tidens advokat: ”Vänta, vi behöver tid att tänka efter här.” Detta att låta saker ta sin tid får sällan gehör i samhället. Det börjar redan i skolan, där det ofta gäller att kunna räkna snabbt och kunna rabbla så många ord som möjligt på en minut. Det fortsätter sedan på samhällsnivå.

Ett bra exempel är teknikutvecklingen, som går snabbare än någonsin. Människan har alltid använt mer eller mindre avancerad och funktionell teknik, alltid letat efter bra sätt att lösa problem. Med den industriella revolutionen började det gå riktigt snabbt, sedan har hastigheten bara ökat. Vi fick fabriker, biltrafik, flygtrafik, kärnkraft, genmodifierade grödor och fosterdiagnostik. Vi fick skrivmaskiner, datorer och telefoner. Vi fick olika sätt att spela och spela upp musik. Nu har vi har vi fått artificiell intelligens (AI), som det ofta sägs kommer att revolutionera de flesta delar av samhället.

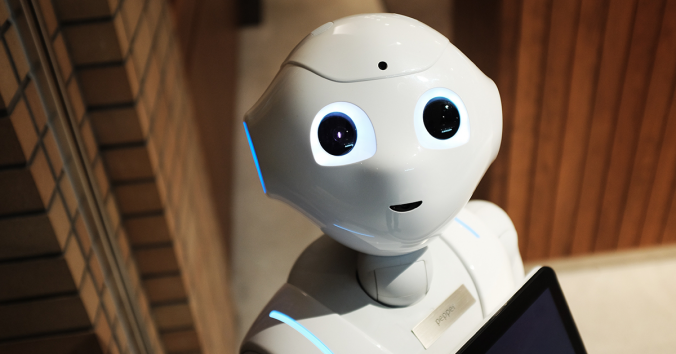

Utvecklingen och implementeringen av AI går ojämförligt snabbt. Olika myndigheter använder AI, hälso- och sjukvården tillåter att AI-verktyg får allt fler uppgifter. Skolor och universitet brottas med frågan hur AI ska användas av studenter, lärare och forskare. Lärare har stått handfallna eftersom AI etablerade sig så snabbt, och olika lärare har olika sätt att dra gränser för vad som är fusk, vilket resulterar i stor otydlighet för studenter om vad som gäller. Människor använder AI för allt från att planera sin dag till att få hjälp med psykiska problem. AI används som relationsexpert, men också som själva föremålet för romantiska relationer eller vänskapsrelationer. Det finns idag AI som kan ringa upp gamla och sjuka människor och fråga dem hur de känner sig, om de tagit sin medicin, och kanske om de har haft några sociala kontakter den senaste tiden.

Precis som med all teknik finns det fördelar och nackdelar med AI, och den kan användas på både bra och dåliga sätt. AI kan användas för att förbättra för människor och miljö, men liksom all teknik kan den också vara skadlig för människor och miljö. Människor och samhällen kan göra saker bättre och enklare med AI, men liksom all teknik kan den också få negativa konsekvenser som miljöförstöring, arbetslöshet och diskriminering.

Forskare i Nederländerna har diskuterat problemen som uppstår med ny teknik i termer av ”sociala experiment”. De menar att det finns en viktig skillnad jämfört med den noggranna prövning som exempelvis nya läkemedel genomgår. Läkemedel testas i laboratorier och djurförsök innan de godkänns. Ny teknik genomgår inte en lika strukturerad process.

EU har infört ett grundläggande juridiskt ramverk kring AI (EU AI Act), vilket kan ses som ett försök att introducera den nya tekniken på ett sätt som är mindre experimenterande med människor och samhällen: mer ”ansvarsfull” och ”pålitlig” AI. Den nya lagen kritiseras av vissa europeiska teknikföretag som hävdar att lagen innebär att vi hamnar efter de länder som inte har några regler, till exempel USA och Kina. Att göra saker på ett genomtänkt och etiskt riktigt sätt betraktas tydligen som mindre viktigt än att snabbt få tekniken på plats. Tvärtom betraktas eftertänksamhet som riskfyllt, vilket säger en del om det riskbegrepp som för närvarande framtvingar en så snabb utveckling att kanske inte ens tekniken hinner leverera vad marknaden förväntar sig.

Precis som med tidigare viktiga tekniker skulle vi behöva tänka efter innan. Om AI ska hjälpa oss utan skadliga konsekvenser så måste utvecklingen få ta sin tid. Detta är ännu viktigare med AI än med tidigare teknik, eftersom AI har ovanligt stor potential att påverka våra liv. Etikforskningen pekar på flera problem som har att göra med rättvisa och tillit. Ett problem är att vi inte kan förklara varför AI i sjukvården kommer till en viss slutsats om en patients hälsotillstånd. Med tidigare teknik har någon person, om inte användaren så åtminstone utvecklaren, alltid kunnat förklara kausaliteten i systemet. Vågar vi lita på en teknik i sjukvården som vi inte kan kontrollera eller förklara på väsentliga punkter?

Det finns teknikoptimister och teknikpessimister. Vissa är entusiastiska över ny teknik och tror att den är lösningen på alla våra problem. Andra anser att försiktighetsprincipen borde gälla för all ny teknik och vill inte acceptera några risker alls. Det vore bra om vi kunde se medelvägen. Medelvägen består i att låta saker ta sin tid att visa sina reella möjligheter bortom optimisternas och pessimisternas förutfattade meningar om saken. Att förespråka ett etiskt förhållningssätt handlar alltså inte om att sätta stopp för utvecklingen, utan om att sakta ner processen. Detta för att vi ska få tid att reflektera över var det kan vara lämpligt att införa AI och var vi kanske borde avstå från tekniken. Vi borde också fundera över hur den AI som vi väljer att använda introduceras på ett bra sätt, så att vi hinner upptäcka riskerna för orättvisa, diskriminering och minskad tillit och kan minimera dem.

Det är inte lätt och inte populärt att vara den som säger ”Vänta, vi måste tänka efter”. Ändå är det så viktigt att vi tar oss tid. Vi måste tänka efter före, så att det inte blir fel när det så lätt hade kunnat bli rätt. Det kan vara värt att fundera över vad som kunde hända om vi fick lära oss i skolan att det är viktigare att göra saker rätt än att göra dem snabbt.

Skrivet av…

Jessica Nihlén Fahlquist, lektor i biomedicinsk etik och docent i praktisk filosofi vid Centrum för forsknings- & bioetik.

Läs även SvD 2025-10-20: ”AI – ett experiment på samhällsnivå?”

Vi deltar i debatten