Kanske använder du Google Maps när du tar dig runt i en ny stad. Frågar Siri, Alexa eller Ok Google att spela din favoritlåt på Spotify, Kanske ber du din AI hitta något du vill köpa på Amazon, eller läsa upp ett meddelande från en kompis när du sitter i bilen. Bilen kanske har en semi-autonom adaptiv farthållare… För att det ska fungera behöver mjukvaran i de olika maskinerna samla in information: Data om dig, vart du är på väg, vilken musik du gillar, var och vad du brukar handla, vilka dina vänner är och vad ni pratar om. Och såklart väcker det frågan om du är villig att ge upp en del av ditt privatliv och en bit av din personliga frihet för att kunna dra nytta av fördelarna som den här typen av teknik har att erbjuda.

Kanske använder du Google Maps när du tar dig runt i en ny stad. Frågar Siri, Alexa eller Ok Google att spela din favoritlåt på Spotify, Kanske ber du din AI hitta något du vill köpa på Amazon, eller läsa upp ett meddelande från en kompis när du sitter i bilen. Bilen kanske har en semi-autonom adaptiv farthållare… För att det ska fungera behöver mjukvaran i de olika maskinerna samla in information: Data om dig, vart du är på väg, vilken musik du gillar, var och vad du brukar handla, vilka dina vänner är och vad ni pratar om. Och såklart väcker det frågan om du är villig att ge upp en del av ditt privatliv och en bit av din personliga frihet för att kunna dra nytta av fördelarna som den här typen av teknik har att erbjuda.

Det är svårt att förutse konsekvenserna av att utveckla och använda ny teknik. Myndigheter och organisationer sliter med att utvärdera etiken, juridiken kring tekniken. Och vilka konsekvenser den kan få för mänskliga rättigheter. Vi använder IT-system i forskning, inom industrin och i våra hem. Regleringen av systemen behöver fungera för alla som berörs av den. Vi vill skydda etiska värden och mänskliga rättigheter, möjliggöra forskning och utveckling, ta innovationer från universiteten till industrin, och se till att både stora och små företag kan utveckla sina affärsidéer. Och samtidigt se till att det finns acceptans i samhället för teknikutveckling.

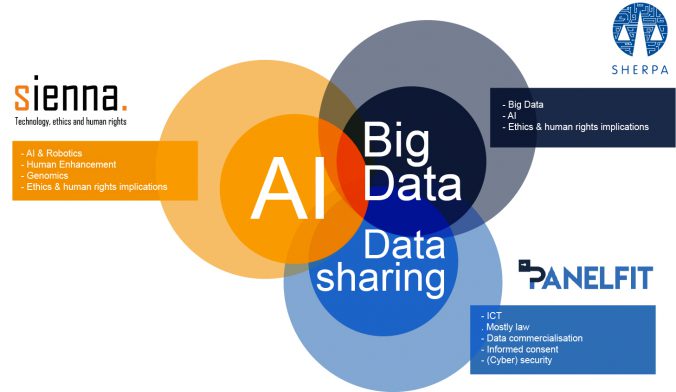

EU tar det här på allvar och vill utveckla policy som bygger på forskning, empiriska data och konsultationer med de aktörer som är berörda. De senaste åren har EU investerat 10 miljoner Euro i tre forskningsprojekt som ska ta sig an etiken och mänskliga rättigheter kopplat till utvecklingen av nya digitala teknologier. Satsningen har skett genom Horizon2020-programmet och projekten PANELFIT, SHERPA och SIENNA.

Det första projektet, PANELFIT (som står för Participatory Approaches to a New Ethical and Legal Framework for ICT), kommer att utveckla riktlinjer för hur man ska hantera etiken och juridiken kring forskning och innovation på informations- och kommunikationsteknikområdet. Det andra projektet, SHERPA (som står för Shaping the ethical dimensions of Smart Information Systems (SIS) – A European Perspective), kommer att utveckla olika verktyg för att identifiera och hantera de etiska aspekterna av ”smarta” informationssystem. Det vill säga IT-system som kombinerar artificiell intelligens med analys av stora datamängder. Det tredje projektet, SIENNA (som står för Stakeholder-informed ethics for new technologies with high socio- economic and human rights impact), kommer att utveckla verktyg för forskningsetikkommittéer, etiska koder för olika yrkesgrupper, och bättre etiska och legala ramverk för AI och robotik, men också genetik och genomik och teknologi som kan användas för att förbättra människors egenskaper.

Alla projekten arbetar på olika sätt med att engagera både olika intressenter och allmänheten. De stödjer EUs vision om ansvarsfull innovation (det som på engelska kallas för RRI, eller Responsible Research and Innovation). Projekten samarbetar och SIENNA, SHERPA och PANELFIT har nyligen publicerat en gemensam artikel i tidskriften Orbit, där vi bjuder in alla er som på något sätt berörs av de här frågorna att prata med oss och på så sätt bidra till vårt arbete.

Vill du läsa mer? Rowena Rodrigues och Anaïs Resseguier har skrivit om nåra av frågorna som användandet av AI väcker på bloggen Ethics Dialogues (The underdog in the AI and ethical debate: human autonomy). Du kan också läsa mer om SIENNA-projektet i en tidigare post här på Etikbloggen (Ethics, human rights and responsible innovation).

Vill du veta mer om samarbetet mellan SIENNA, SHERPA och PANELFIT? I så fall hoppas jag att du vill läsa vår artikel i Orbit (Setting future ethical standards for ICT, Big Data, AI and robotics: The contribution of three European Projects), eller följa oss på YouTube och se en video från vårt gemensamma webbinarium den 20 maj i år (SIENNA, SHERPA, PANELFIT: Setting future ethical standards for ICT, Big Data, SIS, AI & Robotics).

Vill du veta hur SIENNA-projektet tänker omkring AI och robotik? Ladda ner infografiken i pdf-format här och läs vår state-of-the-art review för AI och robotik (rapport från SIENNA projektet).

![]()

Senaste kommentarer